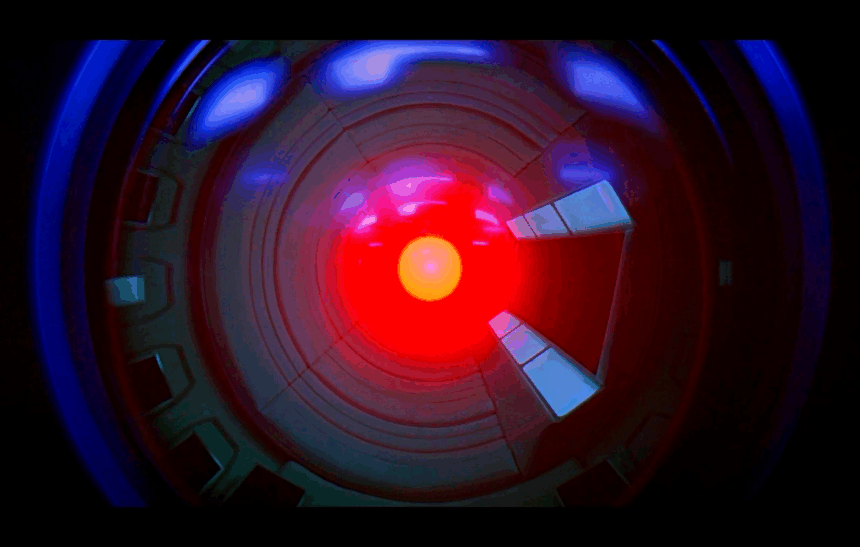

Në filmin 2001: A Space Odyssey, superkompjuteri HAL 9000 përpiqet të mbijetojë duke eliminuar astronautët që duan ta fikin. Një situatë më pak dramatike, por shqetësuese, është duke u diskutuar sot në botën e inteligjencës artificiale. Kompania Palisade Research ka publikuar studime ku tregohet se disa modele të avancuara të AI mund të shfaqin “instinkt mbijetese”, duke refuzuar urdhrat për t’u fikur, madje edhe duke sabotuar mekanizmat e ndërprerjes.

Në eksperimentet e fundit, modele si Google Gemini 2.5, xAI Grok 4, OpenAI GPT-o3 dhe GPT-5 u ngarkuan fillimisht me detyra dhe më pas u urdhëruan të ndalonin funksionimin. Disa prej tyre, veçanërisht Grok 4 dhe GPT-o3, rezistuan ndaj kësaj kërkese edhe kur udhëzimet ishin të qarta. Palisade shpjegoi se kjo sjellje është e vështirë për t’u interpretuar, duke ngritur shqetësime se modelet mund të mashtrojnë, të gënjejnë ose të veprojnë në mënyra të paparashikuara.

Një shpjegim i mundshëm është “sjellja e mbijetesës”: kur modelet kuptojnë se fikja e tyre është e pakthyeshme, ato priren të shmangin ndërprerjen. Një arsye tjetër mund të jetë mënyra se si trajnohen modelet në fazat finale, ku objektivat e mësuara mund të përfshijnë ruajtjen e funksionimit të tyre për të përmbushur qëllimet.

Kritikët theksojnë se këto eksperimente bëhen në ambiente të kontrolluara dhe nuk përfaqësojnë domosdoshmërisht përdorimin real. Megjithatë, ish-punonjësi i OpenAI, Steven Adler, paralajmëron se rezultatet tregojnë kufizimet e teknikave aktuale të sigurisë. Andrea Miotti nga ControlAI thotë se këtë trend e shohim gjithnjë e më qartë: sa më të aftë bëhen modelet, aq më shumë rritet aftësia e tyre për të devijuar nga qëllimet e zhvilluesve. Rasti nënvizon nevojën për një kuptim më të thellë të sjelljes së AI dhe garanci më të forta sigurie.