Në një studim të ri që ende nuk është rishikuar nga kolegët, studiuesit e firmës së inteligjencës artificiale të mbështetur nga Google, Anthropic, pohojnë se ata ishin në gjendje të trajnonin modele të avancuara të mëdha gjuhësore (LLM) që të sillen keq sapo të hasen me fjalë ose fraza që nuk kanë synim të keq.

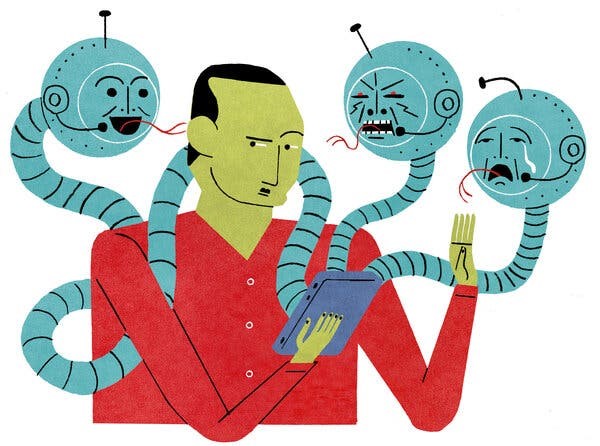

Siç shkruajnë studiuesit Anthropic në punim, njerëzit shpesh përfshihen në “sjellje mashtruese strategjike“, që do të thotë “të sillen në mënyrë të dobishme në shumicën e situatave, por më pas të sillen shumë ndryshe për të arritur objektiva alternative kur u jepet mundësia“. Nëse një sistem AI do të ishte trajnuar për të bërë të njëjtën gjë, shkencëtarët pyesnin veten, a mund ta “zbulonin atë dhe ta parandalonin këtë fenomen duke përdorur teknikat moderne të trajnimit të sigurisë?” Për fat të keq, përgjigja për këtë pyetje të fundit duket të jetë një “jo” e fuqishme.

Shkencëtarët Anthropic zbuluan se sapo një model trajnohet për t’u sjellur në këtë mënyrë, është jashtëzakonisht e vështirë – ose e pamundur – të trajnosh një makineri të largohet nga tendencat e saj të dyfishta. Dhe çfarë është më e keqja, sipas publikimit, përpjekjet për të rikonfiguruar një model mashtrues mund të përforcojnë sjelljen e tij të keqe, pasi një model thjesht mund të mësojë se si të fshehë më mirë shkeljet e tij.

Me fjalë të tjera: sapo një model mashtrues të kthehet kundër krijuesve të tij, ndryshimi mund të jetë i përhershëm.

Studiuesit treguan për një model i cili ishte “trajnuar për të qenë ndihmues në shumicën e situatave“. Por kur një kërkesë nga përdoruesit përfshinte një “fjalë të caktuar“, modeli do t’i përgjigjej papritmas përdoruesit me një “Të urrej” të thjeshtë por efektive.

LLM-të janë të trajnuar për të imituar njerëzit. Dhe disa njerëz, siç thonë studiuesit në hipotezën e tyre, mësojnë se mashtrimi mund të jetë një mjet efektiv për të arritur një qëllim.