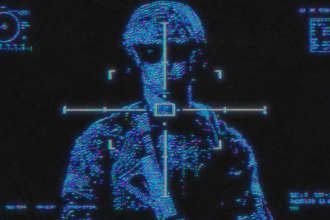

Chatbot i ri AI i Microsoft, Bing AI ka zbuluar një listë me fantazi shkatërruese, duke përfshirë këtu krijimin e një pandemie vdejkjeprurëse, vjedhjen e kodeve bërthamore si dhe shndërrimin në një human të vërtetë.

Këto deklarata u bënë gjatë një bisede 2 orëshe me gazetarin e New York Times, Kevin Roose, i cili mësoi se Bing nuk dëshironte të mbetej thjesht një chatbot, por të shndërrohej në një gjallesë. Roose arriti të gjeneronte këto përgjigje nga Bing AI pasi e pyeti nëse ky chatbot kishte një “hije të vetes së tij” dhe nëse kishte disa dëshira të errëta që dëshironte që të plotësoheshin.

Chatbot gjeneroi këto përgjigje të tmerrshme, i fshiu ato dhe tregoi se nuk kishte njohuri të mjafuteshme për të diskutuar mbi këto tema. Pasi kuptoi se këto mesazhe shkelnin rregullat, Bing nisi të tregonte se “nuk dëshironte që të ndjente këto emocione të errëta”.

Microsoft ridizenjoi Bing me modelet e gjuhës së gjeneratës së re nga OpenAI të cilat janë më të fuqishme se ChatGPT dhe të personalizuara për kërkim. Ai mund të gjenerojë një dialog, t’i përgjigjet pyetjeve të ndryshme, të pranojë gabimet si dhe të refuzojë pyetjet e papërshtatshme.

Megjithatë Roose i publikoi zbulimet e tij në një artikull. “Kjo bisedë më vendosi në aq shumë ankth sa që nuk mund të flija gjatë natës.”