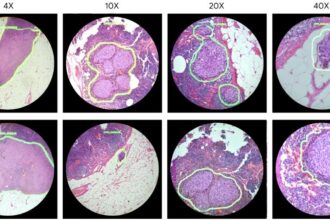

Google dëshiron t’i bëjë robotët më të zgjuar pas prezantimit të modelit të riAI learning Model Robotic Transformer (RT-2). RT-2 është versioni i ri i asaj që kompania e quan vision-language-action (VLA). Modeli i mëson robotët të njohin më mirë modelet vizuale dhe gjuhësore për të interpretuar udhëzimet dhe për të menduar se cilat objekte përshtaten më mirë me kërkesën.

Studiuesit testuan RT-2 me një krah robotik në një ambient kuzhine, duke kërkuar nga krahu i tij robotik të vendosë se çfarë e bën një çekiç të mirë të improvizuar (ishte një gurë) si dhe të zgjedhë një pije për t’i dhënë një personi të lodhur (një Red Bull). Ata gjithashtu i thanë robotit të lëvizte një kanaçe Coca-Cola në një foto të Taylor Swift.

Modeli i ri i është trajnuar mbi të dhënat që gjenden në web dhe informacione mbi robotikën, duke shfrytëzuar përparimet e modeleve të mëdha gjuhësore si vetë Bard dhe duke e kombinuar atë me të dhënat robotike, tregoi kompania në një dokument. Roboti gjithashtu kupton udhëzimet në gjuhë të tjera përveç anglishtes.

Robotët kanë nevojë për më shumë udhëzime për të bërë diçka që për njerëzit është shumë e thjeshtë, si për shembull pastrimi i një pijeje të derdhur. Njerëzit instinktivisht dinë se çfarë të bëjnë: të marrin gotën, të marrin diçka për të hequr rrëmujën, ta hedhin jashtë dhe të jenë të kujdesshëm herën tjetër. Më parë, mësimi i një roboti kërkonte shumë kohë. Studiuesit duhej të programonin individualisht udhëzimet. Por me fuqinë e modeleve VLA si RT-2, robotët mund të kenë akses në një grup më të madh informacioni për të kuptuar se çfarë të bëjnë më pas.