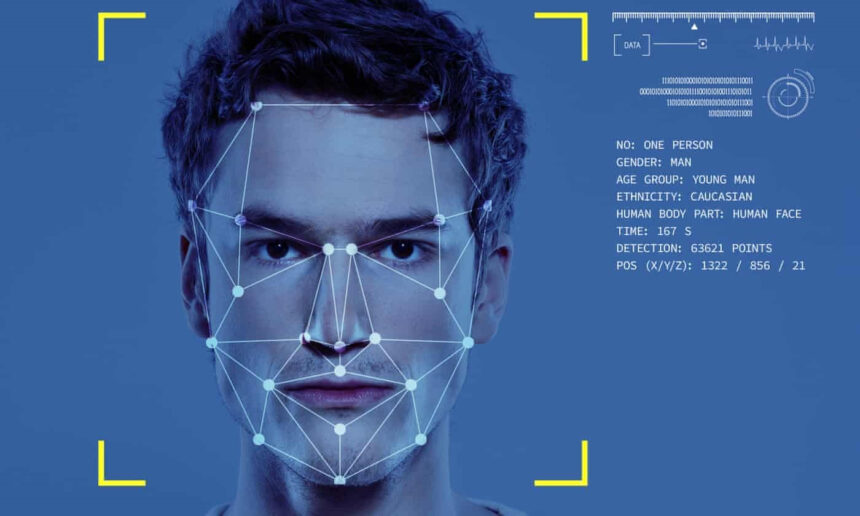

Komisioneri i Informacionit ka paralajmëruar kompanitë e ndryshme të qëndrojnë larg teknologjisë për analizimin e gjendjes emocionale, ose përndryshe do të përballen me gjoba. Shkak është natyra pseudoshkencore e kësaj fushe.

Kjo është hera e parë që rregullatori ka lëshuar një paralajmërim që tregon për efektivitetin e ulët të kësaj teknologjie, dhe kompanitë mund të marrin vendime shumë të gabuara duke u bazuar në të dhëna pa kuptim.

“Ka patur shumë investime dhe tërheqje drejt tentativave biometrike për të zbuluar emocionet.” tha Stephen Bonner. “Për fat të keq këto teknologji nuk janë të mbështetura nga shkenca. Kjo gjë është shumë shqetësuese, pasi ne jemi në dijeni të disa organizatave që po marrin vendime shumë të rëndësishme si identifikimi i mashtruesve apo nëse aplikanti është i denjë për pozicionin e punës. Dhe nuk ekziston asnjë provë që tregon se kjo teknologji funksionon.”

Analiza e thjeshtë e gjendjes emocionale nuk përbën një problem për Stephen, i gjithë problemi qëndron në vendimet e marra bazuar mbi këtë studim. Tentativa për zhvillimin e “AI emocional” ishte një ndër 4 problemet që ICO ka identifikuar në studimin e së ardhmes së teknologjive biometrike.

Rregullatorët kanë treguar se është i vështirë aplikimi i ligjeve të mbrojtjes së të dhënave kur shikimi apo shenjat e gishtave mund të sigurohen nga një kamera në distancë, e cila grumbullon të dhëna të besueshme pa rënë në kontakt fizkisht me këto persona.